Nvidia Cuda GPU연산을 위한 기본 Core수를 알자.

| NVIDIA Card 3000 Series |

Number of CUDA Cores |

Memory Type | Memory Interface Width |

Memory Bandwidth GB/sec |

Base Clock Speed |

Boost Clock Speed |

NOTES |

| RTX-3050 | 2560 | GDDR6 | 128 bit | 224 GB/s | 1550 MHz | 1780 MHz | Standard with 8 GB of Memory |

| RTX-3060 | 3584 | GDDR6 | 192 bit | 384 GB/s | 1320 MHz | 1780 MHz | Standard with 12 GB of Memory |

| RTX-3060 Ti | 4864 | GDDR6 | 256 bit | 448 GB/s | 1410 MHz | 1670 MHz | Standard with 8 GB of Memory |

| RTX-3070 | 5888 | GDDR6 | 256 bit | 448 GB/s | 1580 MHz | 1770 MHz | Standard with 8 GB of Memory |

| RTX-3070 Ti | 6144 | GDDR6X | 256 bit | 608 GB/s | 1500 MHz | 1730 MHz | Standard with 8 GB of Memory |

| RTX-3080 | 8704 | GDDR6X | 320 bit | 760 GB/s | 1440 MHz | 1710 MHz | Standard with 10 GB of Memory |

| RTX-3080 Ti | 10240 | GDDR6X | 384 bit | 912 GB/s | 1370 MHz | 1670 MHz | Standard with 12 GB of Memory |

| RTX-3090 | 10496 | GDDR6X | 384 bit | 936 GB/s | 1400 MHz | 1700 MHz | Standard with 24 GB of Memory |

| NVIDIA Card 2000 Series |

Number of CUDA Cores |

Memory Type | Memory Interface Width |

Memory Bandwidth GB/sec |

Base Clock Speed |

Boost Clock Speed |

NOTES |

| RTX-2060 | 1920 | GDDR6 | 192 bit | 336 GB/s | 1365 MHz | 1680 MHz | Standard with 6 GB of Memory |

| RTX-2060 Super | 2176 | GDDR6 | 256 bit | 448 GB/s | 1470 MHz | 1650 MHz | Standard with 8 GB of Memory |

| RTX-2070 | 2304 | GDDR6 | 256 bit | 448 GB/s | 1410 MHz | 1620 MHz | Standard with 8 GB of Memory |

| RTX-2070 Super | 2560 | GDDR6 | 256 bit | 448 GB/s | 1605 MHz | 1770 MHz | Standard with 8 GB of Memory |

| RTX-2080 | 2944 | GDDR6 | 256 bit | 448 GB/s | 1515 MHz | 1710 MHz | Standard with 8 GB of Memory |

| RTX-2080 Super | 3072 | GDDR6 | 256 bit | 496 GB/s | 1650 MHz | 1815 MHz | Standard with 8 GB of Memory |

| RTX-2080 Ti | 4352 | GDDR6 | 352 bit | 616 GB/s | 1350 MHz | 1545 MHz | Standard with 11 GB of Memory |

| Titan RTX | 4608 | GDDR6 | 384 bit | 672 GB/s | 1350 MHz | 1770 MHz | Standard with 24 GB of Memory |

| NVIDIA Card 1600 Series |

Number of CUDA Cores |

Memory Type | Memory Interface Width |

Memory Bandwidth GB/sec |

Base Clock Speed |

Boost Clock Speed |

NOTES |

| GTX-1650 | 896 | GDDR5 | 128 bit | 128 GB/s | 1485 MHz | 1665 MHz | Standard with 4 GB of Memory |

| GTX-1650 Super | 1280 | GDDR6 | 128 bit | 192 GB/s | 1530 MHz | 1725 MHz | Standard with 4 GB of Memory |

| GTX-1660 | 1408 | GDDR5 | 192 bit | 192 GB/s | 1530 MHz | 1785 MHz | Standard with 6 GB of Memory |

| GTX-1660 Super | 1408 | GDDR6 | 192 bit | 336 GB/s | 1530 MHz | 1785 MHz | Standard with 6 GB of Memory |

| GTX-1660 Ti | 1536 | GDDR6 | 192 bit | 288 GB/s | 1500 MHz | 1770 MHz | Standard with 6 GB of Memory |

| NVIDIA Card 1000 Series |

Number of CUDA Cores |

Memory Type | Memory Interface Width |

Memory Bandwidth GB/sec |

Base Clock Speed |

Boost Clock Speed |

NOTES |

| GTX-1010 | 384 | GDDR5 | 64 bit | 41.1 GB/s | 1228 MHz | 1468 MHz | Standard with 2 GB of Memory |

| GTX-1030 | 384 | GDDR5 | 64 bit | 48 GB/s | 1277 MHz | 1468 MHz | Standard with 2 GB of Memory |

| GTX-1050 2GB | 640 | GDDR5 | 128 bit | 112 GB/s | 1354 MHz | 1455 MHz | Standard with 2 GB of Memory |

| GTX-1050 3GB | 768 | GDDR5 | 96 bit | 84 GB/s | 1392 MHz | 1518 MHz | Standard with 3 GB of Memory |

| GTX-1050 Ti | 768 | GDDR5 | 128 bit | 112 GB/s | 1290 MHz | 1392 MHz | Standard with 4 GB of Memory |

| GTX-1060 3GB | 1152 | GDDR5 | 192 bit | 192 GB/s | 1506 MHz | 1708 MHz | Standard with 3 GB of Memory |

| GTX-1060 6GB | 1280 | GDDR5 | 192 bit | 192 GB/s | 1506 MHz | 1708 MHz | Standard with 6 GB of Memory |

| GTX-1070 | 1920 | GDDR5 | 256 bit | 256 GB/s | 1506 MHz | 1683 MHz | Standard with 8 GB of Memory |

| GTX-1070 Ti | 2432 | GDDR5 | 256 bit | 256 GB/s | 1607 MHz | 1683 MHz | Standard with 8 GB of Memory |

| GTX-1080 | 2560 | GDDR5 | 256 bit | 320 GB/s | 1607 MHz | 1733 MHz | Standard with 8 GB of Memory |

| GTX-1080 Ti | 3584 | GDDR5X | 352 bit | 484 GB/s | 1480 MHz | 1582 MHz | Standard with 11 GB of Memory |

https://www.studio1productions.com/Articles/NVidia-GPU-Chart.htm

NVidia Graphics Card Specification Chart - Studio 1 Productions and David Knarr

GTX 760 Ti 1344 500 watt DDR5 256 bit 192.2 GB/s 980 MHz 1033 MHz 2 GB Standard Memory Size GeForce 405 16 300 watt DDR3 64 bit 12.6 GB/s 580 MHz 1402 MHz OEM Video Card - Not Recommended GT 420 OEM 48 300 watt DDR3 128 Bit 700 MHz 1400 MHz OEM Video Card

www.studio1productions.com

'작업 > Cuda' 카테고리의 다른 글

| Cuda Block Thread 설정. (0) | 2020.05.26 |

|---|---|

| 기존 Project Cuda Link時 오류 (1) | 2020.05.06 |

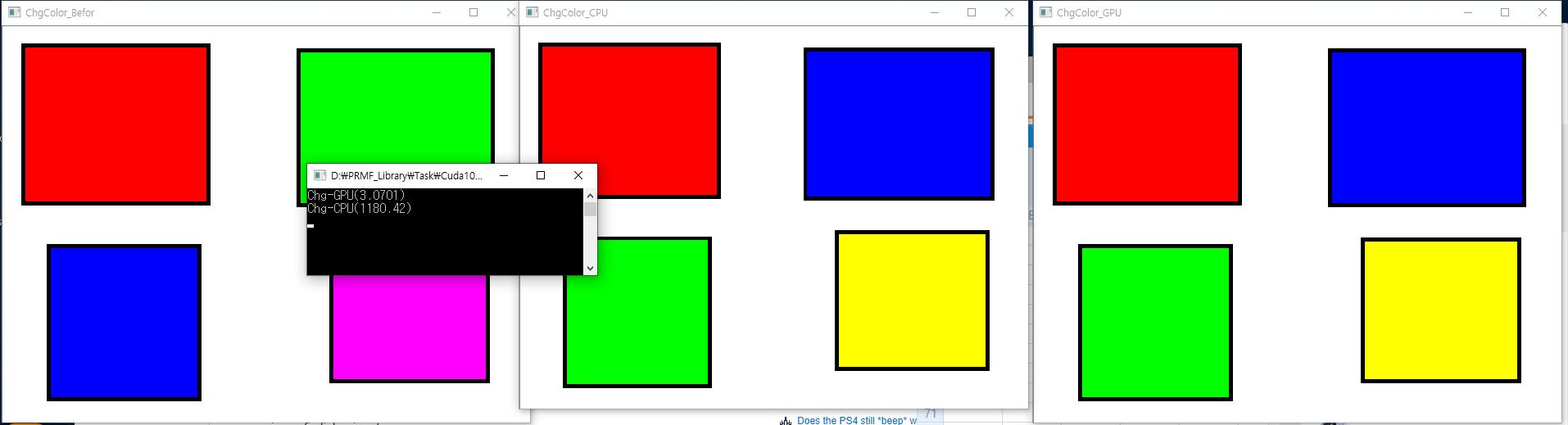

| CPU-GPU 속도 Test (0) | 2019.12.03 |

| VS2017 - NVIDIA Cuda 연결 (0) | 2019.12.03 |